强化学习必修课:从基础到AI前沿

从零掌握强化学习:7大核心算法与AI实战指南

1. 为什么这门课程值得深度学习从业者选择

《强化学习实战:从基础到AI前沿》系统覆盖从数学基础到前沿算法的完整知识体系,通过48节精讲视频构建"理论推导+环境配置+代码实现"三维能力。课程独创性地将马尔可夫决策过程、DQN、PPO等核心概念与Gym平台实战结合,特别适合希望突破传统监督学习框架的开发者。

课程最大特色是每章配备可运行的Python代码,包括Dyna-Q算法实现、大模型RLHF项目等企业级应用场景,帮助学员避开"只懂理论不会编程"的学习陷阱。2. 课程内容模块深度解析

基础构建层(1-3章)从线性代数、概率论延伸到CUDA环境配置,建立扎实的数学与工具基础。核心算法层(4-7章)详解价值迭代、策略梯度、演员评论家等7大算法家族,包含5种改进型实现方案。前沿拓展层(8-12章)涉及多智能体系统、模仿学习等尖端领域,并通过AlphaStar等案例揭示工业界应用逻辑。

关键代码实践如近端策略优化(PPO)实现、深度确定性策略梯度(DDPG)等均提供PyTorch和TensorFlow双版本,适配不同开发环境需求。3. 区别于同类课程的5大优势

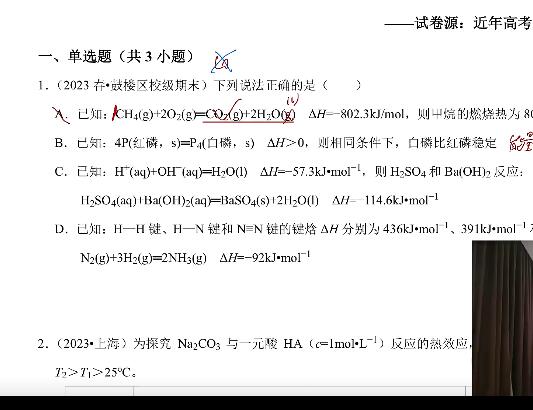

1. 数学可视化教学:动态演示贝尔曼方程迭代过程

2. 工业级项目闭环:从Gym游戏到大模型RLHF完整链路

3. 算法对比实验:Q-Learning与SARSA的决策差异可视化

4. 最新技术覆盖:包含基于人类反馈的强化学习(RLHF)等前沿内容

5. 故障排查指南:专门章节解决CUDA版本冲突等环境配置难题4. 适合哪类学习者进阶

本课程采用渐进式难度曲线设计:

- 初学者可通过1-3章掌握必备数学工具

- 中级开发者能快速实现4-7章的算法复现

- 资深工程师可深入研究MBPO、MADDPG等高级主题

特别推荐给希望将强化学习应用于游戏AI、机器人控制、金融量化等场景的技术团队。5. 课程资源与后续成长路径

配套提供Anaconda环境配置文件、Jupyter Notebook案例库和算法速查手册三大学习工具。完成课程后,学员可继续挑战课程推荐的ICML最新论文复现项目,或参与开源社区如Stable-Baselines3的贡献。

通过系统学习动态规划到模型基强化学习的演化路径,开发者能建立完整的决策智能知识框架,掌握解决非结构化决策问题的核心方法论。

资源下载通道

夸克网盘分享

文件大小:2.04GB

资源目录列表:

├─强化学习必修课:引领人工智能新时代│ ├─1_1-1-课程内容和理念.mp4

│ ├─1_2-1-线性代数.mp4

│ ├─1_3-1-CUDA+Anaconda深度学习环境配置.mp4

│ ├─1_4-1-序列建模与概率图模型.mp4

│ ├─1_5-1-动态回归核心思想和原理.mp4

│ ├─1_6-1-蒙特卡洛方法.mp4

│ ├─1_7-1-深度Q网络核心思想和原理.mp4

│ ├─1_8-1-策略梯度核心思想和原理.mp4

│ ├─1_9-1-演员评论家算法核心思想和原理.mp4

│ ├─1_10-1-基于模型的强化学习核心思想和原理.mp4

│ ├─1_11-1模仿学习.mp4

│ ├─1_12-1-项目实战:Gym游戏.mp4

│ ├─2_1-2-认识强化学习.mp4

│ ├─2_2-2-微积分.mp4

│ ├─2_3-2-conda使用命令.mp4

│ ├─2_4-2-马尔可夫观测过程:学会“看”.mp4

│ ├─2_5-2-策略迭代.mp4

│ ├─2_6-2-时序差分方法.mp4

│ ├─2_7-2-DQN-代码实现.mp4

│ ├─2_8-2-蒙特卡洛策略梯度.mp4

│ ├─2_9-2-改进型演员评论家算法.mp4

│ ├─2_10-2-Dyna-Q算法.mp4

│ ├─2_11-2-博弈论与强化学习.mp4

│ ├─2_12-2-项目实战:大模型RLHF.mp4

│ ├─3_1-3-课程使用的技术栈.mp4

│ ├─3_2-3-概率.mp4

│ ├─3_3-3-Jupyter-Notebook快速上手.mp4

│ ├─3_4-3-马尔可夫决策过程:试着-“干”.mp4

│ ├─3_5-3-价值迭代.mp4

│ ├─3_6-3-蒙特卡洛方法和时序差分代码实现.mp4

│ ├─3_7-3-常见问题改进和扩展.mp4

│ ├─3_8-3-策略梯度方法代码实现.mp4

│ ├─3_9-3-演员评论家算法代码实现.mp4

│ ├─3_10-3-Dyna-Q算法代码实现.mp4

│ ├─3_11-3-多智能体强化学习.mp4

│ ├─3_12-3-强化学习最新发展趋势.mp4

│ ├─4_3-4-仿真环境Gym安装.mp4

│ ├─4_4-4-马尔可夫奖励过程:懂得“想”.mp4

│ ├─4_5-4-动态规划代码实现.mp4

│ ├─4_6-4-广义策略迭代.mp4

│ ├─4_7-4-DQN改进算法代码实现.mp4

│ ├─4_8-4-近端策略优化算法.mp4

│ ├─4_9-4-深度确定性策略梯度.mp4

│ ├─4_10-4-基于模型的策略优化.mp4

│ ├─4_11-4-MADDP的代码实现.mp4

│ ├─4_12-4-下一步的学习建议.mp4

│ ├─5_3-5-深度学习库PyTorch的安装.mp4

│ ├─5_4-5-贝尔曼方程:迭代求解价值函数.mp4

│ ├─5_6-5-Q-Learning算法.mp4

│ ├─5_8-5-近端策略优化(PPO)代码实现.mp4

│ ├─5_9-5-DDPG算法代码实现.mp4

│ ├─5_10-5-MBPO的代码实现.mp4

│ ├─5_11-5-AlphaStar系统.mp4

│ ├─6_4-6-模型分类与选择.mp4

│ ├─6_6-6-SARSA算法.mp4

│ ├─6_9-6-软性演员评论家算法.mp4

│ ├─6_11-6-基于人类反馈大强化学习.mp4

│ ├─7_4-7-常见问题解析.mp4

│ ├─7_6-7-Q-Learning&SARSA代码实现.mp4

│ ├─7_9-7-SAC代码实现.mp4

│ ├─8_4-8-马尔可夫过程代码实现.mp4

![七月在线_ 强化学习 [一举解开AlphaGo Zero的百胜奥秘]](https://static.kouhao8.com/sucaidashi/xkbb/f0b4d733b64fc5b42a35d52ebca4e414.jpg?x-oss-process=image/format,webp/resize,w_88/crop,w_88,h_88,g_nw)

![[机器学习/深度学习] 深度学习最前沿技术 Kaggle案例实战课程 深度学习之Kaggle实战指南](https://static.kouhao8.com/sucaidashi/xkbb/8c854a271b0be2dd148fe341334e4c0e.png?x-oss-process=image/format,webp/resize,w_88/crop,w_88,h_88,g_nw)

相关资源